Трамп влюбился в уборщицу: Интернет обманывает всех. Даже искусственный интеллект обманывают. Кому можно доверять?

Если вас в последнее время не бомбардировали сценкой под названием «Трамп влюбился в меня, уборщицу Белого дома», поздравляю, вы, возможно, единственный, кого она не обманула.

Одно только название этой драмы звучит как слащавый и крутой роман, а сюжетная линия сама по себе достаточно волшебна: президент США Трамп влюбляется в Эмили, уборщицу Белого дома, и готов бросить свою жену-супермодель Меланию и жениться на ней, став первой леди. Это настоящая американская версия «Легенды о Чжэнь Хуань» + «Любовный мозг Белого дома».

Эта новость мгновенно облетела все основные социальные сети. Многие известные СМИ, включая инфлюенсеров, которые обычно кажутся весьма проницательными, начали репостнуть эту историю, утверждая, что короткометражка, ставшая вирусным хитом за рубежом, собрала 150 миллионов долларов за три месяца и стала новым фаворитом среди женщин среднего и старшего возраста.

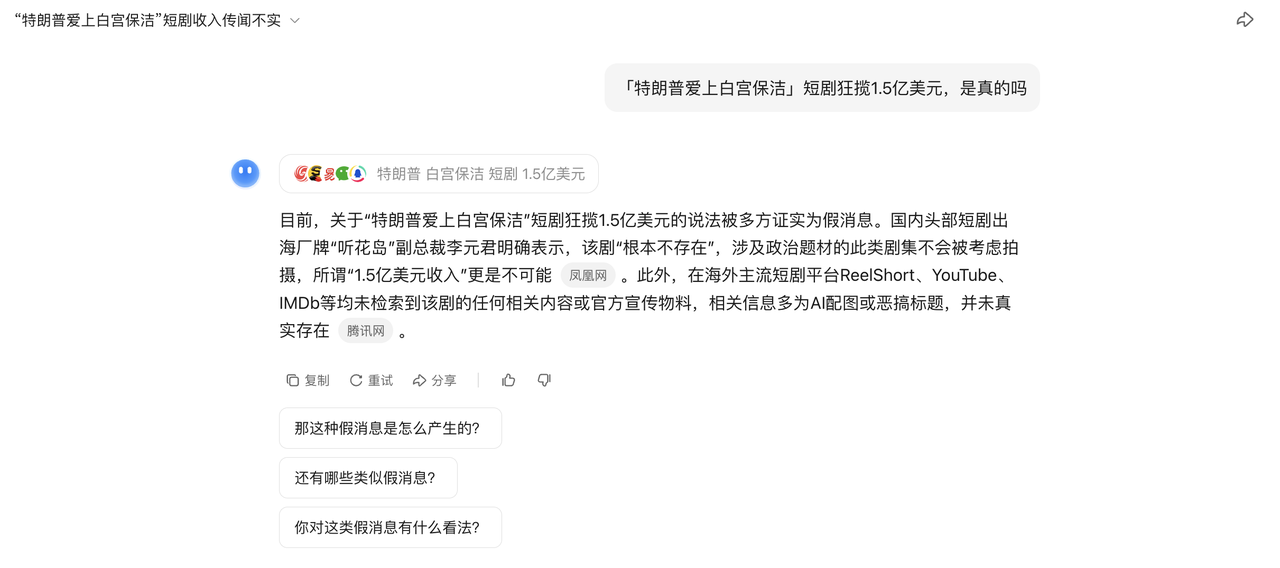

Однако вскоре сюжет развернулся на 180 градусов, и было подтверждено, что короткометражная драма вообще не существовала и была фейком от начала до конца.

Итак, вопрос в том, как шоу, которое никто не видел, всего за несколько дней стало вирусной сенсацией? И как ИИ подогрел ажиотаж, заставив ещё больше людей поверить в эту несуществующую новость?

Что же именно за этим произошло?

Как несуществующая зарубежная короткометражка обманула людей и ИИ?

Если вы думаете, что это просто недоразумение, вы недооцениваете сложность этого общения.

По данным многочисленных источников, история этого фейкового новостного инцидента берёт своё начало 1 июля, когда статья была опубликована в аккаунте под названием «Overseas Student Daily». Аккаунт был выбран в основном для темы «любопытство» и привлечения трафика. Судя по стилю языка и логике контента, статья, вероятно, была написана с помощью инструмента для написания текстов на основе искусственного интеллекта, а затем отредактирована вручную.

Проблема в том, что, несмотря на то, что это стандартное самостоятельное издание, его часто перепечатывают и цитируют авторитетные отечественные СМИ. 23 июля Shin Min Daily News, дочерняя компания сингапурской Lianhe Zaobao, опубликовала статью под названием «Короткометражные сериалы с участием китайских генеральных директоров Overlord приходят в Америку».

Репортаж был очень подробным: утверждалось, что Трамп бросил свою жену-модель Меланию и собирается жениться на матери-одиночке азиатского происхождения, которая убиралась в Белом доме, будучи первой леди. В нём даже говорилось, что шоу заработало 150 миллионов долларов за три месяца. Зрители среднего и пожилого возраста ругались и тратили деньги на шоу, и, ругаясь, платили за просмотр.

▲ Отчет был удален.

Учитывая, что «Ляньхэ Цзаобао» является СМИ с высоким авторитетом в китайском Интернете, эта новость широко разлетелась по отечественным СМИ, а различные короткие видеоблогеры ее интерпретировали… Образовался идеальный замкнутый контур доверия «экспорт для внутреннего сбыта».

Более того, поток коротких, достоверных видеороликов и наглядных репортажей быстро распространился по зарубежным социальным сетям. Эта «фейковая скетчица» стала выдаваться за «настоящие новости», и пользователи по всему миру поверили ей, стали обсуждать её и даже использовать для критики эстетических различий между Китаем и Соединёнными Штатами.

Все серьезно говорили о чем-то несуществующем.

Пока некоторые СМИ не почувствовали неладное и не начали расследование. Сериал не был доступен ни на одной зарубежной платформе (включая ReelShort, YouTube и TikTok), а также отсутствовал на IMDb, ведущей мировой базе данных фильмов и сериалов.

Более того, руководители ведущих китайских компаний, выпускающих короткометражные фильмы, которые работали за рубежом, выступили с опровержением слухов. Например, Ли Юаньцзюнь, вице-президент «Тинхуадао», прямо заявил, что они никогда не будут работать с подобными жанрами. Ключевые доказательства в пользу фейковой новости также были опровергнуты один за другим.

Первое изображение, сатирический фрагмент из варьете-шоу «Saturday Night Live», было лично опровергнуто актёром Ран Ран Шоу. Второе, фотография Трампа с азиаткой, — полная фальшивка: всё изображение выглядит пластиковым, словно создано искусственным интеллектом.

▲Сеть источников изображений

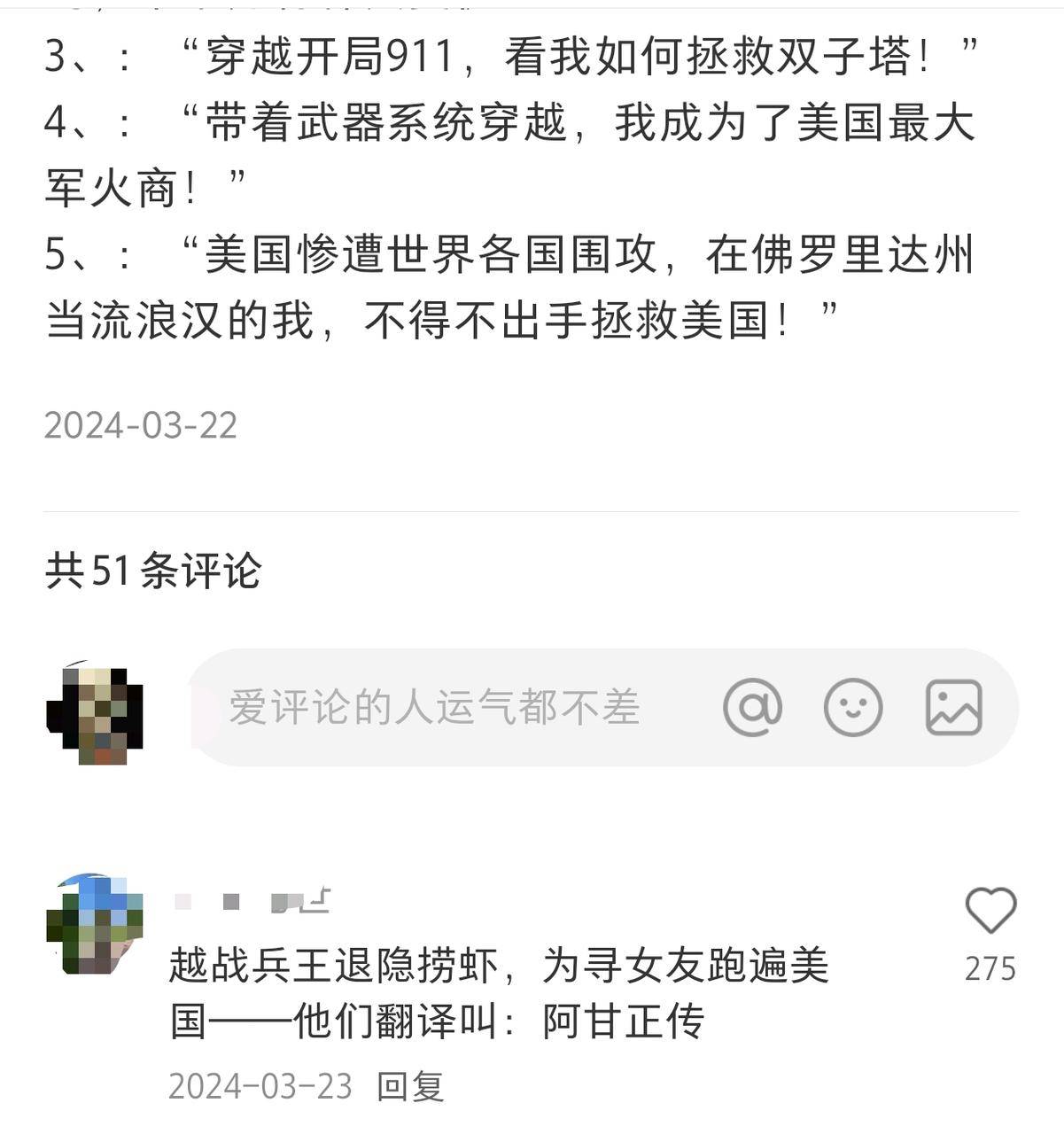

Если пролистать еще дальше назад, то можно найти похожие интересные заголовки, уже активные на социальных платформах:

«Когда началась Гражданская война, Линкольн трижды просил меня выйти из отставки!» «Я путешествовал во времени и пространстве к 11 сентября, вот как я спас Башни-близнецы»… Это, очевидно, названия крутых романов, но по какой-то причине их распределили от одного человека до десяти, а от десяти до ста и упаковали в настоящие зарубежные короткометражные драмы.

▲Скриншот из Интернета

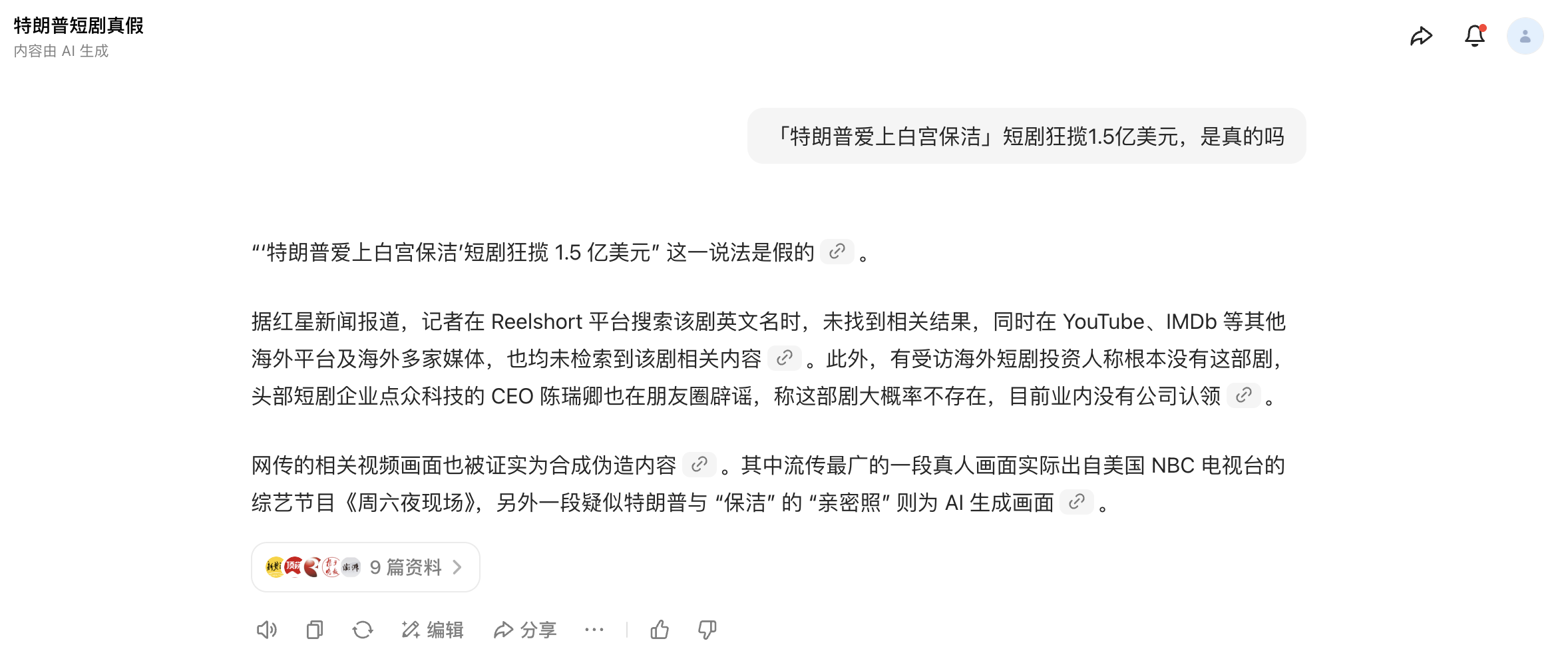

Интересно, что даже искусственный интеллект поверил в этот слух, прежде чем он был опровергнут.

До того, как инцидент был официально опровергнут большим количеством СМИ, я пытался проверить подлинность короткометражки, используя ряд распространённых инструментов искусственного интеллекта. Они по-прежнему уверенно утверждали, что «такая драма действительно существует», и причина по-прежнему заключалась в перекрёстной проверке контента с фотографиями и текстами авторитетных СМИ на разных платформах.

Конечно, поскольку вчера днем большое количество СМИ начали опровергать этот слух, эти инструменты ИИ обновили последние новости и могут правильно определить, что это фейковая новость.

Мы часто говорим, что у поиска ИИ есть проблема «галлюцинаций», поскольку иногда он генерирует, казалось бы, разумные, но совершенно неверные ответы буквально из ничего.

Чтобы «поставить иллюзии» ИИ в «ловушку», производители предприняли множество технических мер: усилили механизмы цитирования, ввели доверенные источники и ограничили свободу действий модели. Однако, когда основа для оценки достоверности новостей ИИ уже основана на фейковых новостях, эти меры могут оказаться неэффективными.

Если ни люди, ни ИИ не надежны, то чему еще мы можем доверять?

Если хорошенько подумать, то сложно сказать, что популярность этой фейковой новости случайна. Хотя история кажется абсурдной, она обладает идеальными генами для распространения.

Он имеет классическую формулу всего популярного контента: четкая структура повествования, иллюстрированные материалы, упакованные данные и четкий ритм распространения.

Становятся ли слащавые сценки вирусными за рубежом? Увлекаются ли американцы среднего и старшего возраста необычными темами? Становится ли TikTok объектом культурного экспорта? Каждое из этих предположений правдоподобно, и, если сложить их вместе, их сложно опровергнуть.

Более того, когда ИИ становится одновременно жертвой и распространителем слухов, это часто происходит из-за злонамеренных манипуляций и продвижения со стороны человека. В частности, большая часть такого контента, создаваемого ИИ, имеет несколько общих характеристик:

Стоимость производства крайне низкая, а сценарий может создать готовый продукт всего за несколько минут; способность к распространению чрезвычайно сильна, а рейтинг кликов остается высоким благодаря сочетанию кликбейтных заголовков и визуального воздействия; повествование чрезвычайно захватывающее, специально атакует человеческие слабости, и в нем всеми возможными способами используется вдохновляющий, сенсационный и любопытный контент, чтобы стимулировать людей.

Недавний инцидент с извинениями DeepSeek перед Ван Ибо — типичный пример. В отчёте под названием «Дело актёра Ван Ибо, вынесен вердикт» утверждалось, что DeepSeek принёс извинения за распространение информации о Ван Ибо, и в качестве доказательства прилагался так называемый «уголовный приговор».

Однако после нескольких этапов проверки фактов было установлено, что это так называемое извинение на самом деле было контентом, автоматически сгенерированным искусственным интеллектом, спровоцированным пользователями сети. Однако из-за профессионального стиля формулировок, чёткой структуры и серьёзного тона некоторые СМИ ошибочно распространили его как настоящее заявление без проверки, что вызвало широкое недопонимание и распространение информации.

Подобные случаи становятся всё более распространёнными. Контент, создаваемый ИИ, проник в интернет, особенно в мультимодальной сфере. Поначалу способность ИИ генерировать реалистичные изображения вызывала огромный ажиотаж, но позже стало появляться всё больше случаев, когда «они берут одно изображение и затем выдумывают всё остальное», что затрудняет распознавание подлинности от подделки.

Например, некоторые люди используют инструменты искусственного интеллекта, такие как ChatGPT, для создания поддельных фотографий или видео неповрежденных товаров (фруктов, одежды, предметов первой необходимости и т. д.), которые выглядят поврежденными, заплесневелыми или испачканными, а затем подают заявки на вредоносный возврат средств, выдавая товары за проблемные, в результате чего большое количество торговцев теряют как свои товары, так и деньги.

В сообщениях о стихийных бедствиях мы также видим, что ИИ начинает часто попадать в поле зрения общественности.

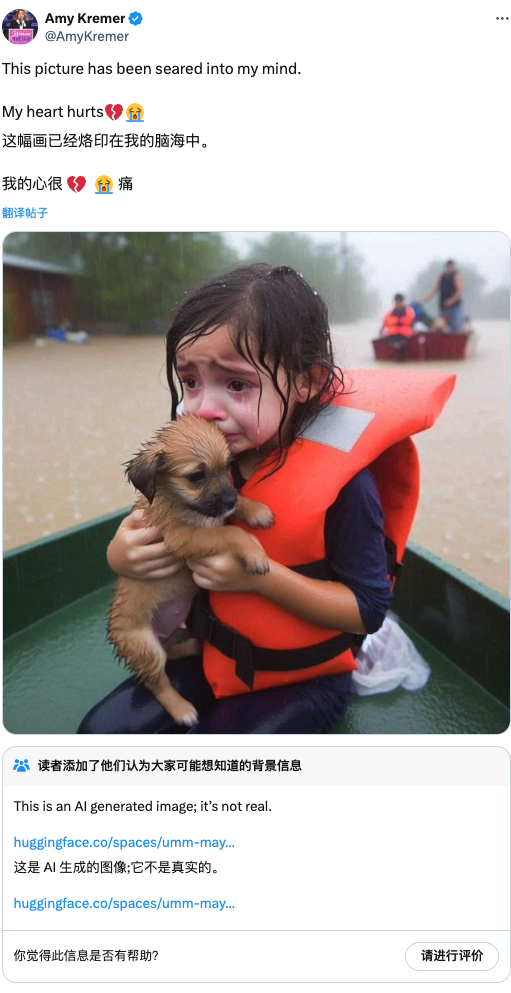

В прошлом году, когда во Флориде произошёл ураган, фотография плачущей девочки в спасательном жилете, держащей щенка в шлюпке, стала вирусной в социальных сетях. Однако в конечном итоге платформа подтвердила, что изображение было создано искусственным интеллектом, что неоправданно отняло сочувствие у добросердечных людей.

Например, в конце октября прошлого года в испанском регионе Валенсия обрушились проливные дожди. Когда вода наконец отступила, появилась следующая сцена. Однако, поскольку всё больше контента становилось трудно верифицировать, общественность начала относиться ко всему с подозрением. Когда люди увидели эту фотографию, первой реакцией многих было: «Это, должно быть, создано искусственным интеллектом. Это фейковые новости».

Поскольку игра в «кричащих волков» продолжает расширяться, новости, которые действительно отражают и сообщают об опасных ситуациях, приписываются «искусственному интеллекту», в результате чего упускается лучшее время для спасения, что также является плохим последствием.

В то же время сложность управления контентом платформы также быстро возрастает.

В отчете об управлении, опубликованном в феврале, Toutiao отметила, что только за последний год она перехватила более 5 миллионов единиц ложной информации, обработала 930 000 единиц некачественного контента с помощью ИИ и наложила штрафы на 7,81 миллиона однородных публикаций.

В некоторых сообщениях СМИ мы также увидели возникновение полной цепочки индустрии производства контента на основе ИИ: фабрики контента, массово выпускающие статьи на основе ИИ, маркетинговые компании, использующие инструменты ИИ для их упаковки и продвижения, и команды SEO, исследующие, как повысить рейтинг контента на основе ИИ в поисковых системах.

Все они изучают одну и ту же тему: как создать контент, которому ИИ с большей вероятностью поверит, и как сделать так, чтобы людям было легче поверить контенту, созданному ИИ.

В июне прошлого года в интернете появился отчёт о мощном взрыве в Сиане, в котором указывалось время и место. Однако полиция Сианя проверила информацию и не обнаружила подобного события. Отчёт был опубликован с аккаунта, принадлежащего агентству MCN.

После ареста полицией главный преступник признался, что использовал инструмент на основе искусственного интеллекта. По команде программа автоматически сканировала соответствующие статьи в интернете и генерировала текст объёмом от сотен до тысяч слов.

На пике своей активности он может генерировать от 4000 до 7000 информационных единиц за один день, практически без участия человека на протяжении всего процесса. Он специально выбирает темы и события, связанные с жизнью людей и пользующиеся большой популярностью. Исследования показали, что негативная, депрессивная и эмоционально стимулирующая информация с большей вероятностью привлечёт внимание людей, что определяется структурой теменных и лобных долей.

Когда эта высокоинтерактивная и легко распространяемая «фейковая информация» часто цитируется, пересылается и индексируется, ничего не подозревающие модели ИИ также воспринимают её как корпус для обучения и включают в свои механизмы генерации. Это создаёт замкнутый цикл между ИИ и людьми:

Люди используют ИИ для создания ложной информации → ИИ узнает ложную информацию → ИИ распространяет ложную информацию → Все больше людей верят ложной информации → Ложная информация становится «установленным фактом» → Новый ИИ продолжает узнавать эти «факты»…

Этот цикл повторяется, образуя спираль слухов. С каждым витком правда размывается, а ложь становится всё более изощрённой и её сложнее обнаружить. Людям нельзя доверять, и заявления ИИ столь же ненадёжны. Наше оставшееся суждение становится нашей последней линией обороны.

Однако в эпоху информационной перегрузки наше суждение разрушается под воздействием различных факторов: предвзятость заставляет нас верить только той информации, которая соответствует нашим существующим знаниям; информационные коконы лишают нас более полной перспективы; а эмоциональное общение также затрудняет рациональное мышление.

Возможно, величайшая истина этой так называемой эпохи постправды заключается в том, что большинство «истин» сомнительны. В частности, следующая скетч «Трамп влюбляется в уборщицу» уже, возможно, не за горами, и она обещает быть ещё более возмутительной и ещё более сложной для разоблачения, чем эта.

#Приглашаем вас следить за официальным публичным аккаунтом WeChat проекта iFaner: iFaner (WeChat ID: ifanr), где в ближайшее время вам будет представлен еще более интересный контент.

iFanr | Исходная ссылка · Просмотреть комментарии · Sina Weibo